字节跳动给AI视频装上“记忆”,Sora们的“变脸”顽疾有救了?

最新AI落地实操,点击了解:https://qimuai.cn/

字节跳动搞了个“记忆系统”,AI生成视频终于不再“变脸”了

你让AI生成一段故事视频。

开头主角还是个黑发少年,切个镜头就变成了金发大叔;明明在客厅聊天,转身推开卧室门,却发现家具风格全变了。

这不是故意搞笑。角色和场景“失忆”,是当前AI视频生成最让人头疼的毛病。

但最近,这个瓶颈被撬开了一道缝。

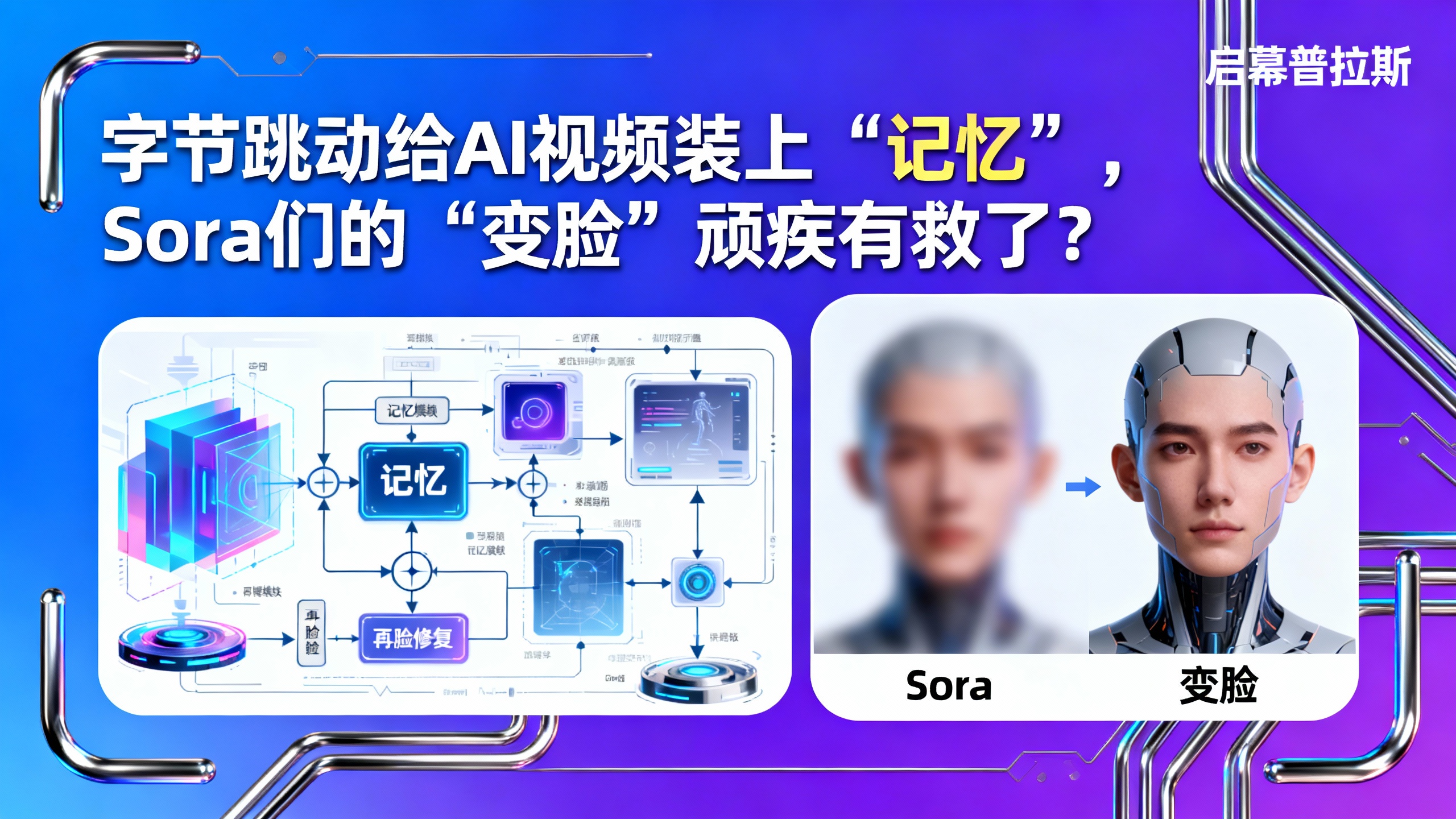

字节跳动和南洋理工大学的团队,联手推出了一个叫 StoryMem 的系统。顾名思义,它想让AI在生成视频时,拥有“故事记忆”。

它到底记住了什么?

简单说,它解决了“跨场景一致性”这个老大难问题。

现有的AI视频工具,无论是Sora、可灵还是Vidu,每生成一个新镜头,都像是从头开始“脑补”。它不知道十秒前的主角穿什么衣服、长什么样,导致角色外观、场景细节像开了随机盲盒。

StoryMem的做法很直观:建一个“记忆库”。

在生成故事的第一幕时,系统会自动提取并存储几个关键帧,比如主角的正面、侧面,以及房间的布局。当故事推进到下一个场景,需要同一个角色或环境出现时,AI不会凭空捏造,而是先去“记忆库”里翻找参考,确保脸还是那张脸,房间还是那个房间。

这就好比给AI导演配了一个场记,随时提醒它:主角的衬衫是蓝色的,客厅有张米色沙发。

研究数据显示,这套方法让跨场景的一致性直接提升了28.7%。数字背后,是AI视频从“幻灯片拼接”向“连贯叙事”迈出的关键一步。

技术是怎么做到的?

背后是几种现有技术的组合拳。

为了让角色动作更自然,它会借用人体关键点检测来指导姿势;为了控制轮廓,它融入了类似ControlNet的控制网络;再加上对比学习和后处理增强,共同打磨生成质量。

本质上,StoryMem不是在创造新技术,而是为AI视频生成设计了一套更靠谱的“工作流”——先记住,再调用。

当然,挑战还在。

目前的“记忆”还比较初级。面对极度复杂的场景,或者角色描述本身就很模糊时,系统依然会犯错。研究人员也承认,要想生成效果稳定,前期给AI的“角色设定”必须足够清晰明确。

但这无疑指出了一个明确的方向:未来的AI视频生成,“一致性”将和“清晰度”、“长度”一样,成为核心的评判维度。

当AI能牢牢记住角色和世界,我们离用自然语言拍出一部真正连贯的微电影,就更近了一步。

所有领域都值得用AI重做一遍。本文作者承接各种AI智能体和AI全域营销自动化软件、工作流开发,了解加微信:qimugood(读者也可此微信一起交流)。

文章标题:字节跳动给AI视频装上“记忆”,Sora们的“变脸”顽疾有救了?

文章链接:https://www.qimuai.cn/?post=2705

本站文章均为原创,未经授权请勿用于任何商业用途